解密 Anthropic 的成功:MCP 胜出之道

从 Anthropic 公司成功的发布和研讨会中获得的经验

2025年3月11日

导读

模型上下文协议(MCP)是2024年11月由Anthropic推出的一项AI原生标准,旨在解决智能体动态上下文访问问题,如今已成为AI工程师圈的热门话题。它从默默无闻到爆火,短短几个月观看量近30万次,甚至有望在7月超越OpenAPI。

MCP亮点不少:它是基于成功的语言服务器协议(LSP)打造,简单易用,比如Cursor这样的工具能快速集成;支持更多工具调用,像Claude Desktop里一次处理多个任务毫不费力;背靠Anthropic强大的开发者品牌,开源生态也日益完善,从客户端到SDK一应俱全;频繁更新的路线图还让它保持活力。

对AI工程师来说,MCP能简化智能体开发,省去繁琐的上下文管理;普通开发者也能用它提升工具效率,比如调试代码或管理文件;投资者则可关注其潜在的生态价值。相比老标准如OpenAPI,它更贴合AI需求,堪称“新瓶装旧酒”的典范。

致各位AI工程师们,

最近 MCP (Model Context Protocol,模型上下文协议) 的讨论可能刷屏了各位的时间线。

模型上下文协议 (MCP) 于2024年11月发布,并且受到了广泛好评。然而,最初的一阵兴奋 (从Copilot到Cognition再到Cursor都增加了支持) 逐渐平息。直到 2 月 26 日至 27 日的 AI 工程师峰会上,我与 Barry Zhang 的一次偶然对话,促使我们邀请了 Mahesh Murag(MCP 服务器的编写者)。我原本只是想对 Anthropic 公司 2023 年和 2024 年的提示工程研讨会做个补充,没想到发生了以下情况:

通常,研讨会对于现场参与者效果很好,但线上观众很少能集中注意力 2 个小时。但这次,研讨会的实时推文开始走红,因为社区首次获得了期待已久的官方注册表公告,以及对协议规范每个部分的全面深入探讨,例如:

之后,我们加快了编辑流程以发布研讨会视频,在过去一周内,总观看次数接近30万次,于是:

到处都是关于MCP的讨论,让人应接不暇。

Latent Space 的一个更高目标是尝试提供比共识稍稍领先的观点。11月,我们说GPT 封装实际上很好,现在a16z对它们感到兴奋。12月,我们告诉那些反对每月 200 美元专业版的人你们都错了,每月 2000 美元的“ChatGPT Max”即将到来,现在我们已经确认计划推出每月 2000-20000 美元的智能体。但我不得不承认,MCP 的受欢迎程度甚至让我感到意外,主要是因为我见过许多试图创建类似XKCD 927标准的尝试都失败了。而 MCP 最初只是作为 Claude Desktop 的一种本地、隐私保护的集成方式提出的,我敢打赌,只有一小部分 AI 工程师下载了它 (相比之下,比如ChatGPT Desktop甚至Raycast AI)。

尽管我们促成了这次研讨会,但我仍然觉得我低估了 MCP。

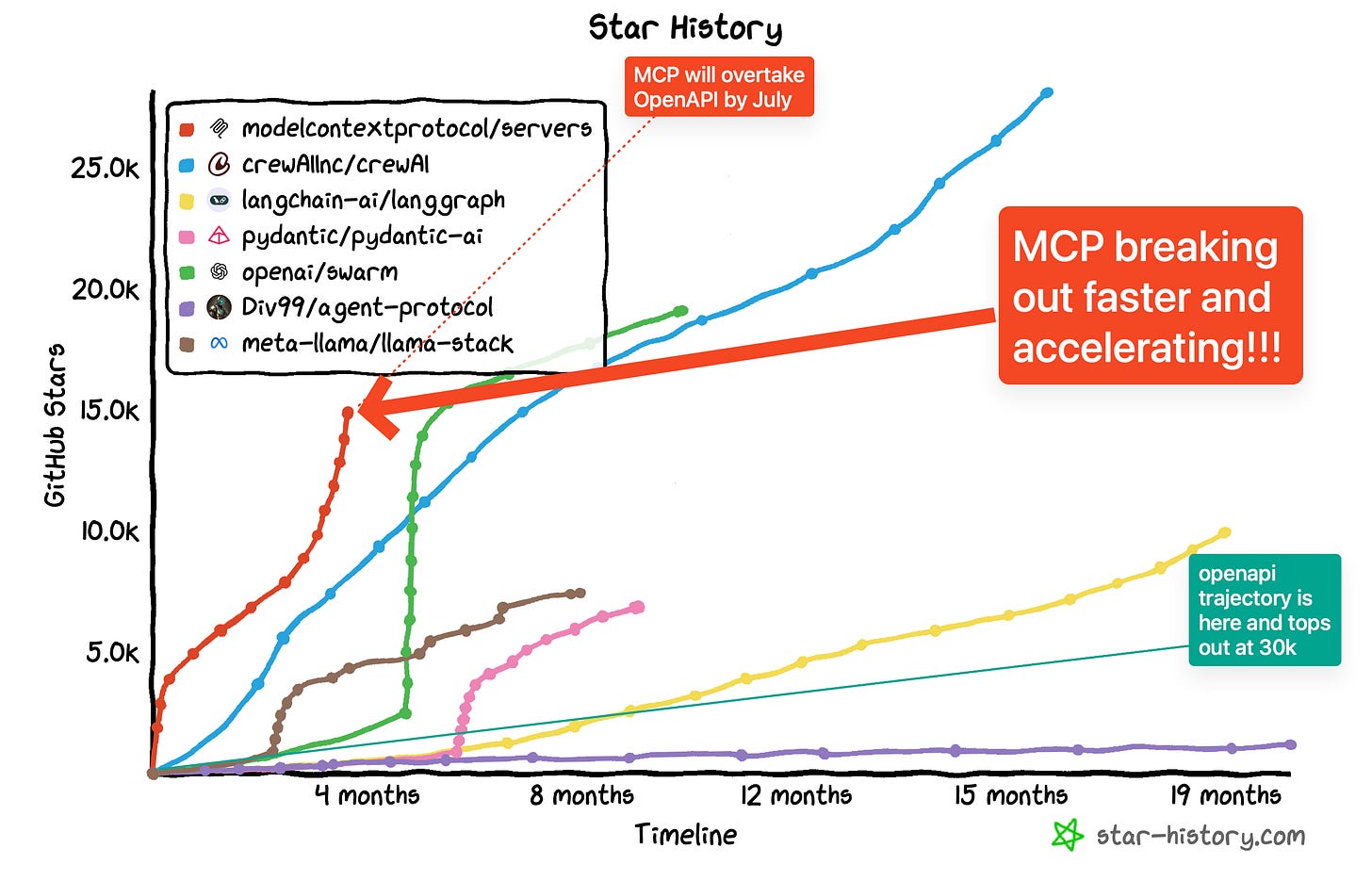

正如 Ben Thompson 所说,任何网络的第一个特征是已经存在于其中的人。因此,任何新协议的力量都来自于它的采用 (也就是生态系统),可以说,MCP 已经获得了足够的临界质量和动力,成为了 2023-2025 年“智能体开放标准”之争的领跑者。按照目前的速度,MCP 将在 7 月份超过 OpenAPI:

自己看看。如果你好奇,可以添加 Langchain,但它会让图表数据失衡。

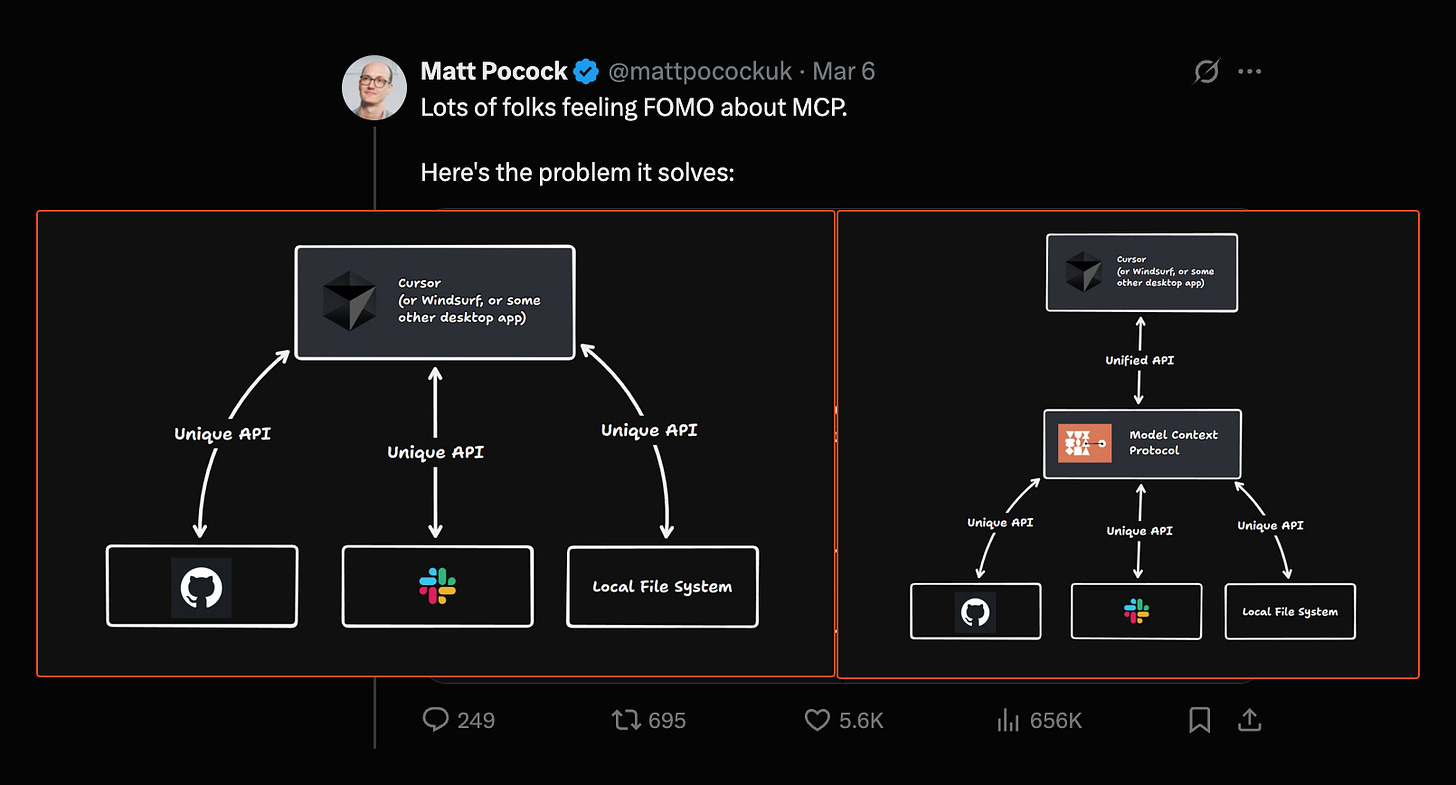

被广泛接受的标准,如 Kubernetes、React 和 HTTP,通过将爆炸性的 MxN 问题转换为易于处理的 M+N 生态系统解决方案,来适应数据发送者和接收者的巨大多样性,因此,如果它们能够获得临界质量,就具有巨大的价值。事实上,即使 OpenAI 也有之前的 AI 标准,甚至Gemini、Anthropic和Ollama都宣传与 OpenAI SDK 兼容。

我并不自大到认为 AI 工程师峰会研讨会导致了这种加速;我们只是在我们已经看到的蔓延的火势上浇了油。但作为一名开发者工具初创公司的学生,其中许多公司试图推动开放标准的建立,但最终都失败了,我觉得我不能错过这个机会,应该深入研究,为未来的标准制定提供参考。此外,我每天都会被问到两次关于 MCP 的想法,所以是时候写下来了。

MCP胜出之道 (简而言之)

也就是“胜出”状态作为事实上的标准,而不是像 OpenAPI 和 LangChain/LangGraph 这样不完全等同但可替代的方法。大致按降序排列。

以下几点促成了MCP的成功:

-

MCP 是旧概念的“AI 原生”版本

-

MCP 是一个有强大支持者的“开放标准”

-

Anthropic 拥有最好的开发者 AI 品牌

-

MCP 基于已经成功的语言服务器协议 (LSP)

-

MCP 通过第一方客户端、服务器、工具和 SDK 进行了内部试用(dogfooding)

-

MCP 从最小的基础开始,但频繁更新路线图

以下几点我们认为令人惊讶地没有促成MCP成功:

-

与 Zed、SourceGraph Cody 和 Replit 等发布合作伙伴合作

-

发布时提供出色的文档

下面我将结合一些截图来详细说明。

哦,看,又一个上帝盒子:“我们可以通过引入一个额外的间接层来解决任何问题。”

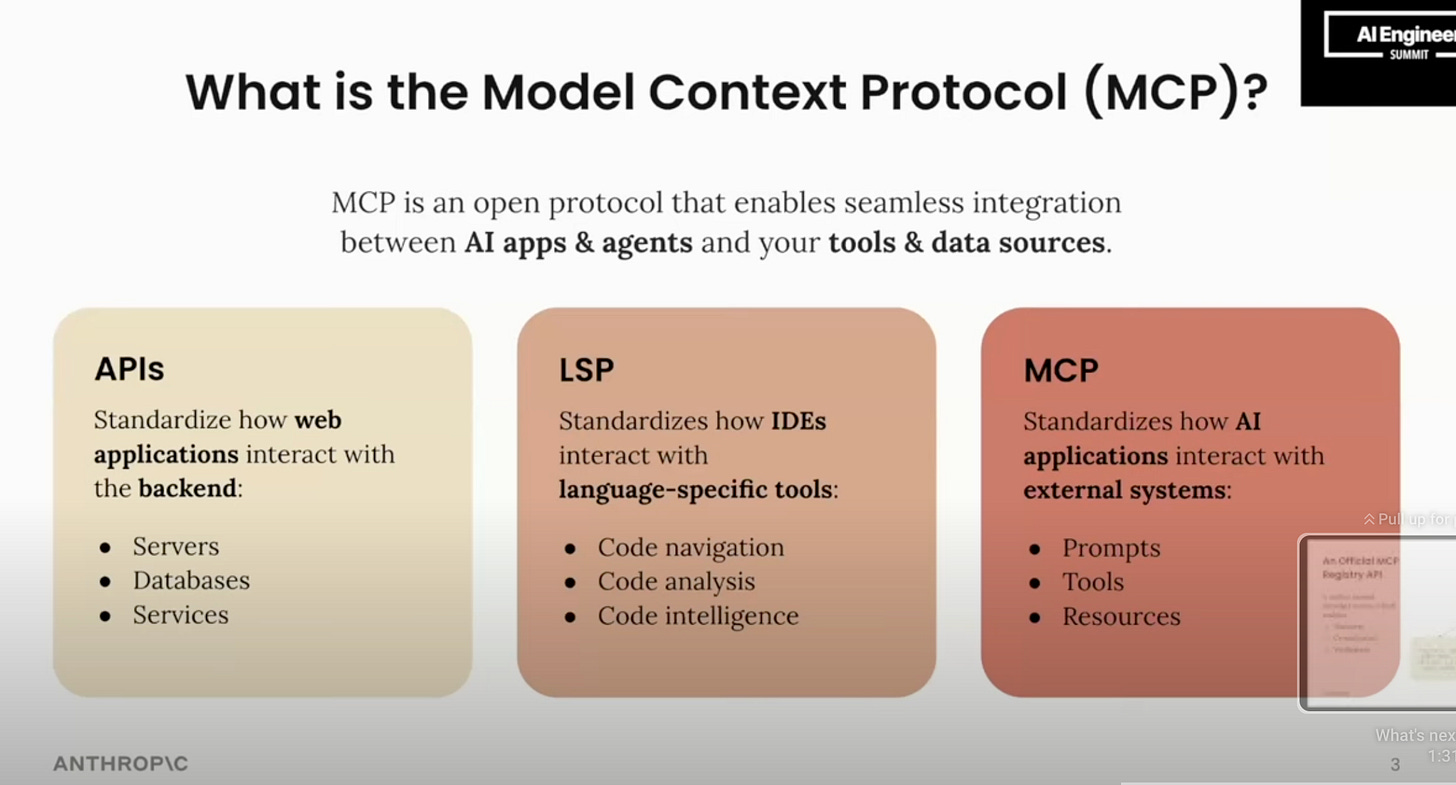

MCP:旧概念的 AI 原生版本

包括我自己在内的许多“老派开发者”最初会对 MCP 的成功感到困惑,因为从技术层面来看,MCP 主要能够实现与 OpenAPI/OData/GraphQL/SOAP 等现有标准相同的功能。因此,隐含的假设是,更老、更符合林迪效应(Lindy effect,指对于一些不会自然消亡的东西,其预期寿命和已经存在的时间成正比)的标准应该胜出。

然而,从技术基础上否定想法就是忽略了人类工程师所处的社会背景。换句话说,说“旧的东西也能做到同样的事情,你应该更喜欢旧的东西”就陷入了每个开发者都会遇到的同样的Lavers定律时尚谬论,这种态度导致人们忽视AI 工程师的崛起,因为你认为它足够接近地映射到现有的工作。套用Eugene Wei的Status as a Service,每一代新的开发者都会积极寻找新的领域来留下自己的印记,基本上是因为你已经在你的领域留下了印记。

协议价值的反身性——记住,它们之所以有价值,是因为它们能够被采用——意味着这些想法中的任何一个都几乎没有事前价值。MCP 之所以有价值,是因为 AI 影响者认为它有价值,因此它确实变得有价值。

它也是一个旧想法的修订版,这意味着它实际上确实满足了我们知道我们拥有的需求,而不是一个未经证实的人造需求。

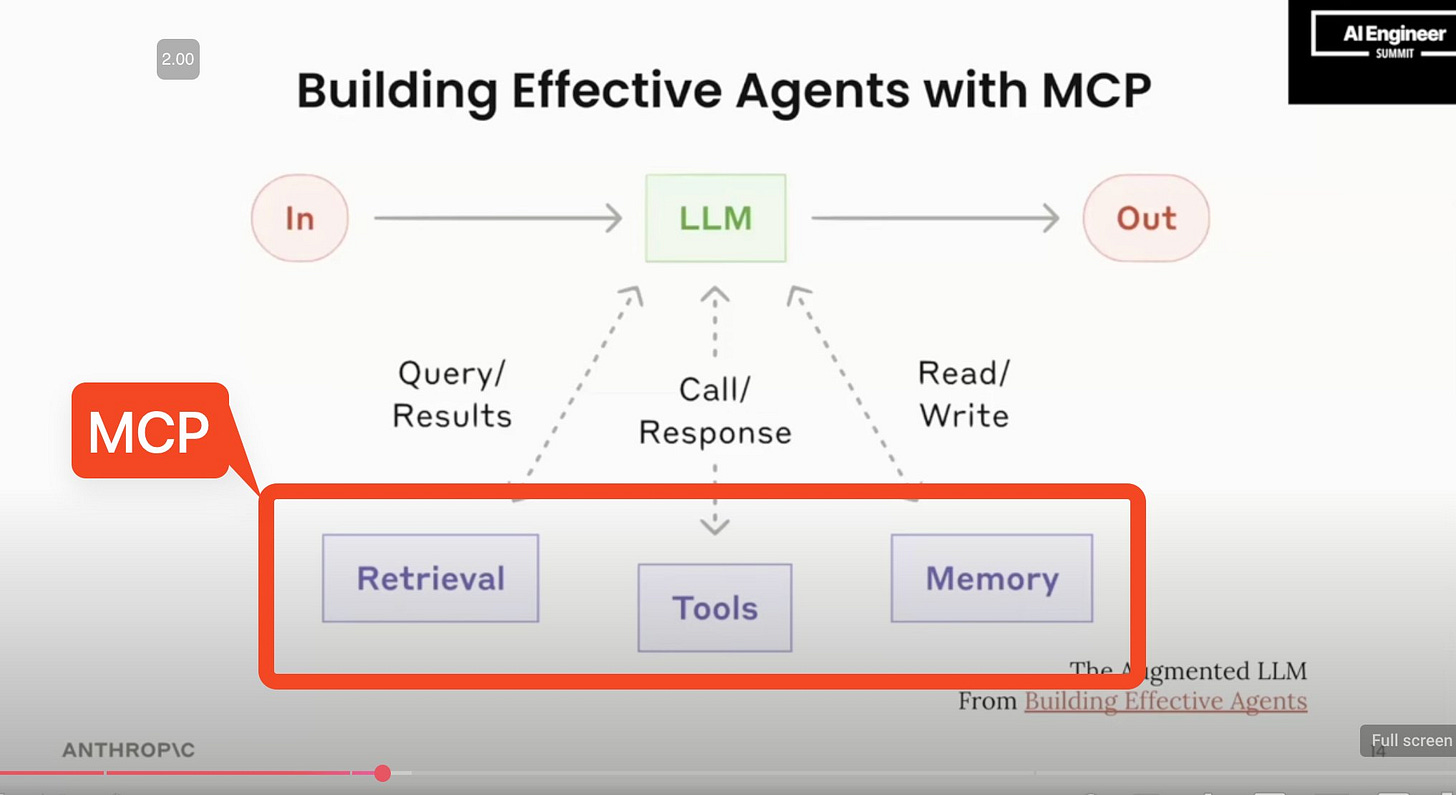

然而,说 MCP 完全等同于 OpenAPI,并且其成功仅仅是愤世嫉俗的潮流周期驱动的,这也是过于轻率的。这就是为什么我选择将这个成功因素描述为“AI 原生”——在这种情况下,MCP 是从Claude Sonnet 在 SWE-Bench 基准测试中排名第一的结果中吸取的经验教训,并在构建有效的智能体中阐述的,主要是这张幻灯片:

一个“AI 原生”标准,将每个智能体中已经独立重复出现的模式具体化,将永远比一个没有这些偏见设计的不可知标准更符合人体工程学,更易于使用和构建工具。

因此,MCP 在与 OpenAPI 的竞争中胜出。

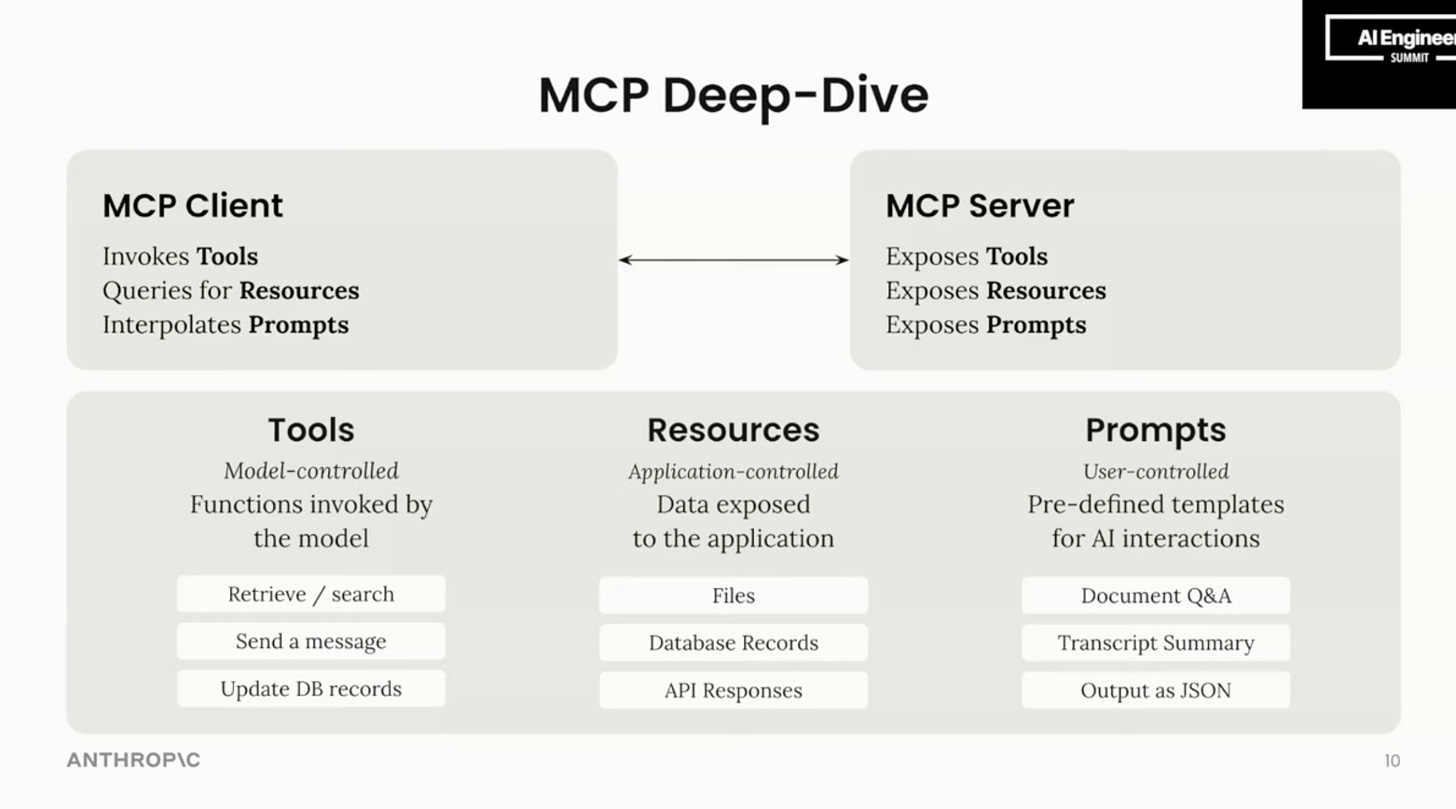

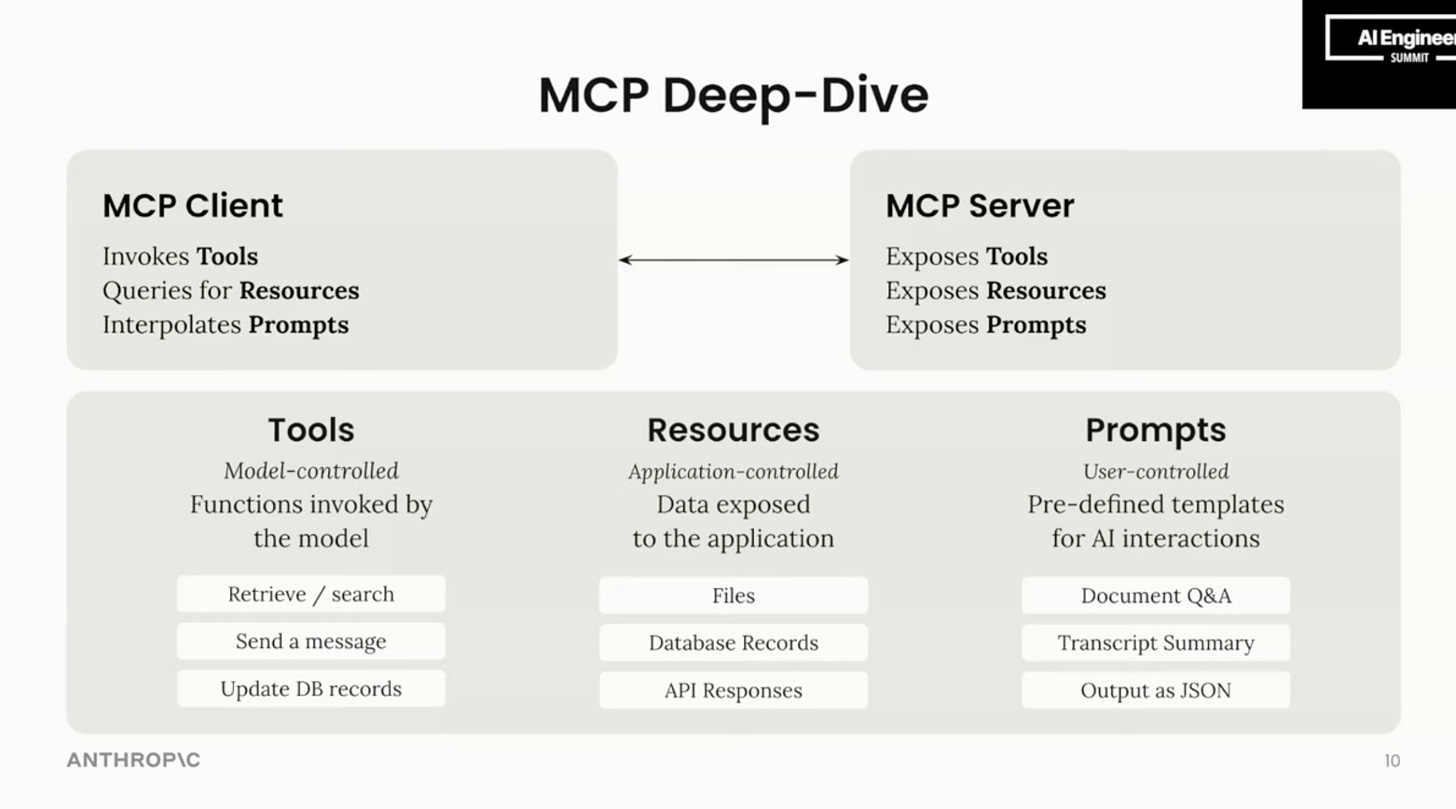

其次,回到这张幻灯片,重点关注工具(模型控制)、资源(应用程序控制)和提示(用户控制)之间阐述的差异。

MCP 的“AI 原生”性是在第一波 LLM 框架之后诞生的,这意味着它有足够的喘息空间来抵制做“显而易见”的事情,即从 LLM 互操作性开始(现在已解决的问题,可能由客户端和网关拥有),而只专注于动态上下文访问这一核心问题。

MCP 的优势:Anthropic 拥有最佳的开发者 AI 品牌

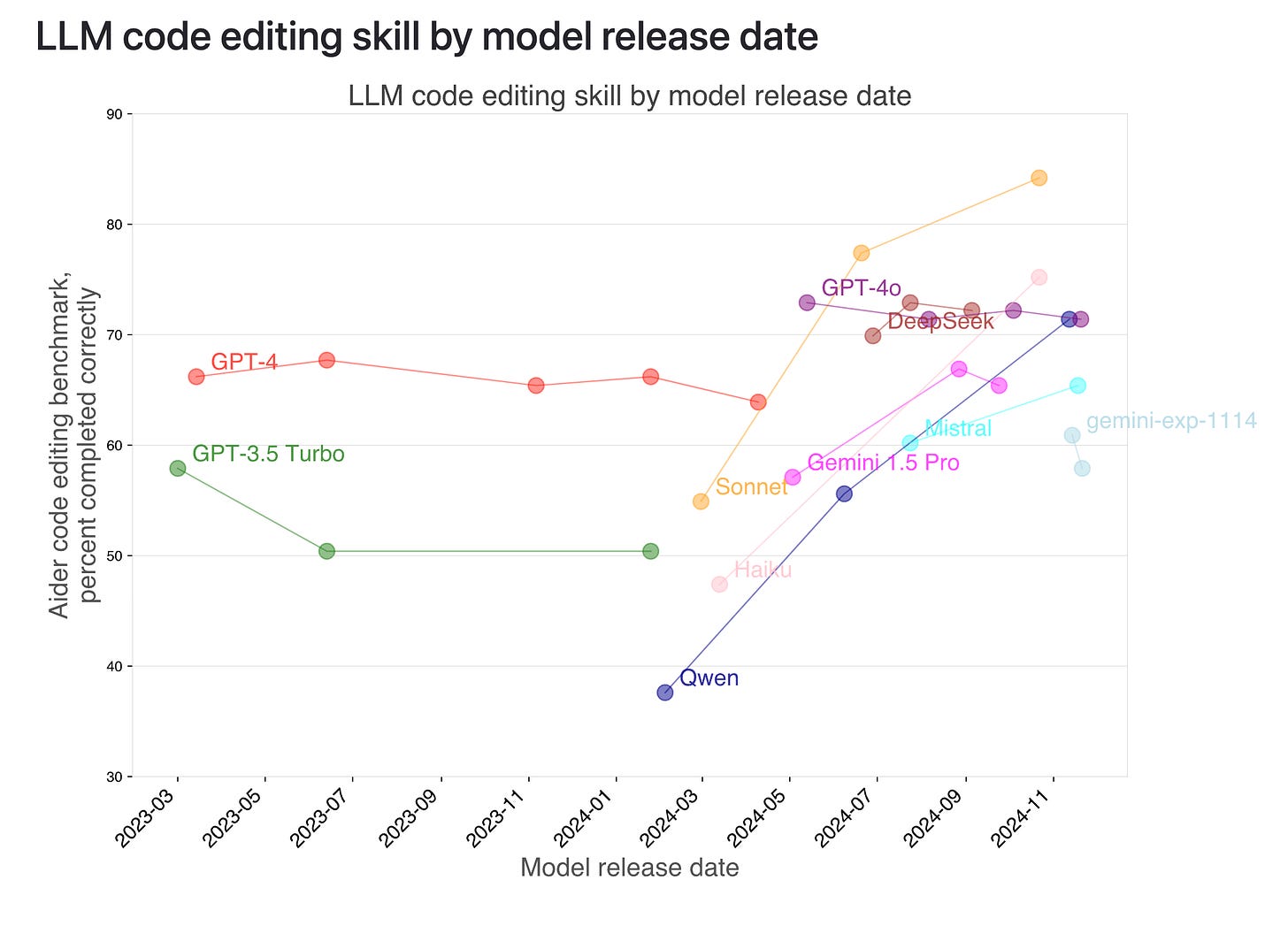

或许与背后有大公司支持同样重要的是,是哪家大公司在支持。如果要建立一个开发者标准,那么受到开发者的喜爱会有很大帮助。 在这方面,Sonnet 已经领先了近 9 个月。

https://aider.chat/docs/leaderboards/by-release-date.html

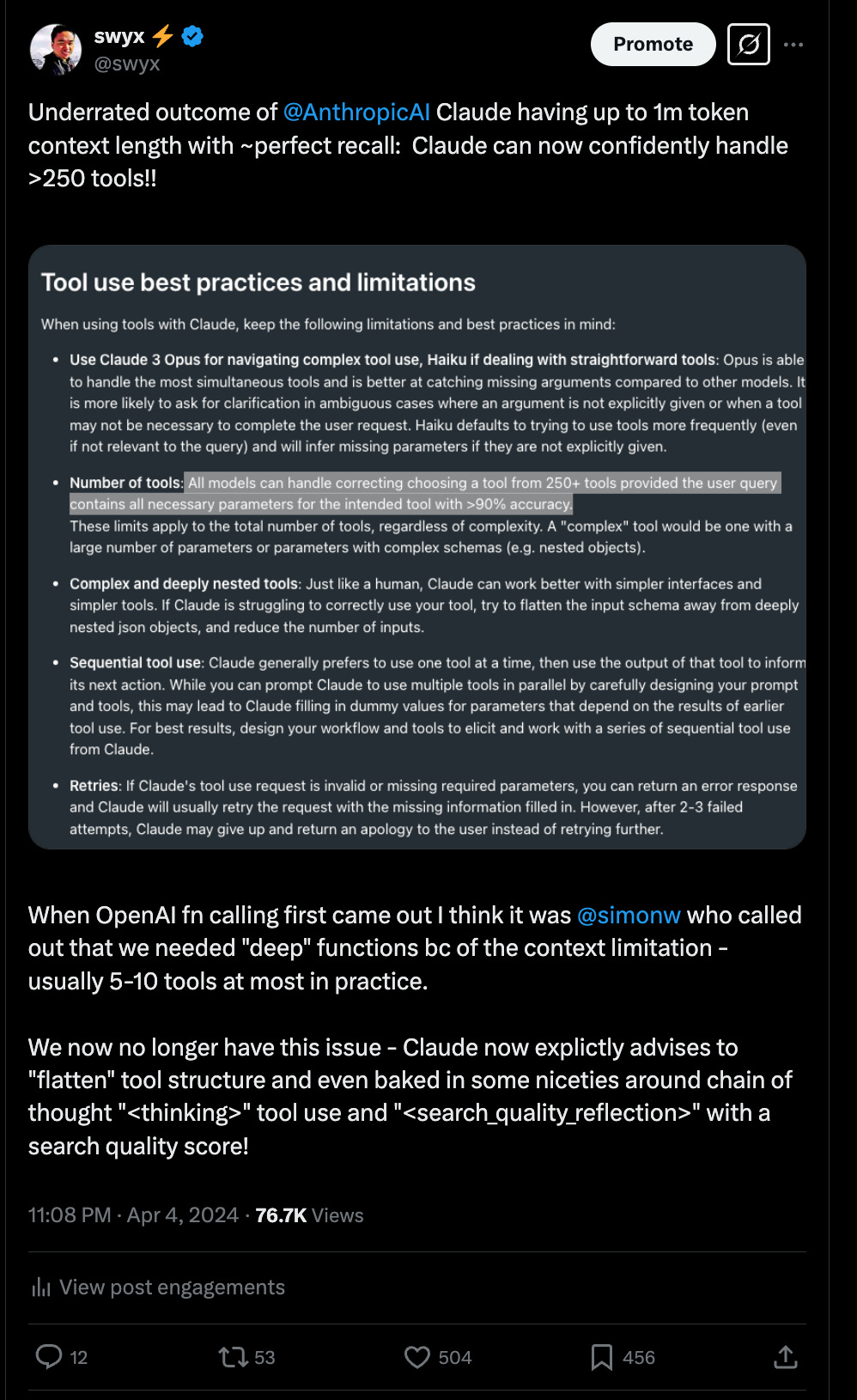

新手可能不太容易注意到一个更微妙的点:Anthropic 一直明确强调支持比 OpenAI 更多的工具。我们并没有针对大量工具的基准测试或对照实验(即移除部分功能以观察效果的实验),所以我们不知道不同模型实验室之间的能力差异。但是,直观上,MCP 在单次调用中支持的平均工具数量远超不使用 MCP 构建的工具中“正常”的数量(仅仅是因为易于包含,而不是由于任何固有的技术限制)。因此,能够更好地处理更多工具的模型将表现得更好。

https://x.com/swyx/status/1775993946935906645

因此,MCP 优于其他公司(比如 Cisco)提出的类似的开发者标准。

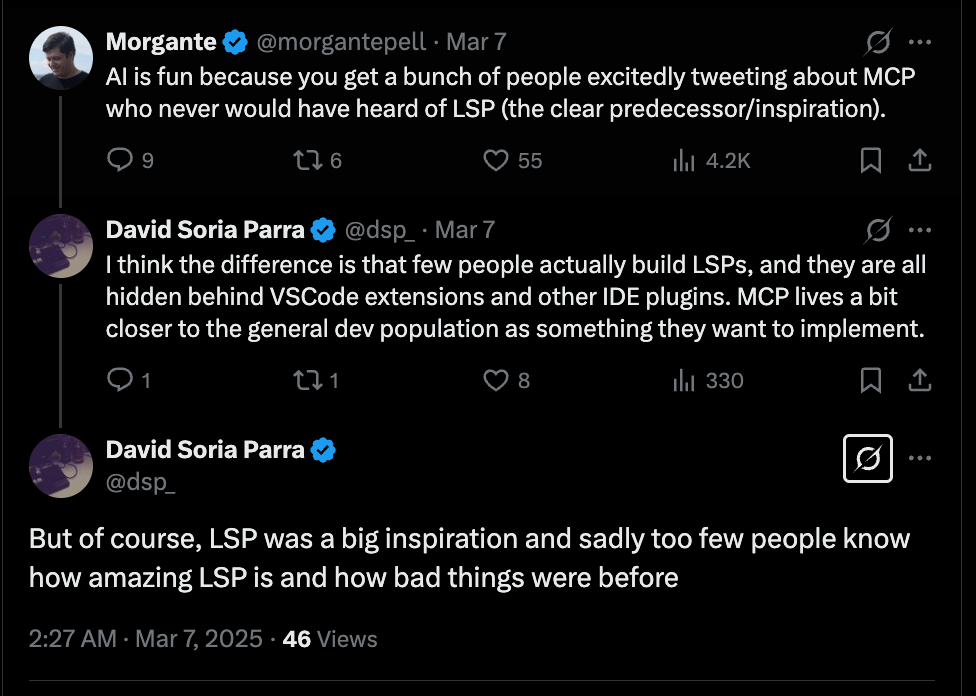

MCP 的优势:基于成功的 LSP 协议

“有大公司支持的‘开放标准’”的另一部分要求该标准没有任何致命缺陷。Anthropic 团队没有从头开始临时发明一个标准,从而避免重蹈覆辙,而是巧妙地采用了微软非常成功的 Language Server Protocol。

https://x.com/dsp_/status/1897821339332882617

同样,从研讨会中可以看出,人们敏锐地意识到了 MCP 与 LSP 的对比:

理解这一点的最佳方式是,看看其他任何试图获得大规模采用的开源 AI 原生竞争者,然后思考一下将它们添加到 Cursor/Windsurf 中是否像 添加 MCP 一样容易。基本的见解是客户端和服务器之间的可互换性。通常这些竞争者被设计为以一种方式使用——作为另一个代码库中的开源包,而不是发出可以被任何人使用的消息8。另一个明智的选择是坚持使用 JSON RPC 作为消息传递方式——同样继承自 LSP。

因此,MCP 胜于其他更“未经证实”的标准格式。

MCP 的优势:完善的第一方生态系统

MCP 发布时包含了:

-

客户端:Claude Desktop

-

服务器:19 个参考实现,包括用于内存、文件系统(Magic!一种文件系统)和顺序思维的有趣实现

此后,最近发布的 Claude Code 也悄然推出了 Anthropic 的第二个官方 MCP 客户端,这次是以 CLI 的形式:

https://x.com/willccbb/status/1898858751685255398

这一切都来自 Anthropic 开发人员的真实用例。

因此,MCP 超越了其他大公司(如 Meta 的 llama-stack)吃自己的狗粮(即公司内部使用自己的产品)较少的尝试。

热门文章

生态伙伴

无论是你是公司创始人,市场人员,文职人员,还是开发人员,你都能在这里找到适合自己的AI工具。

利用AI工具,你可以大幅提高工作效率,从容不迫的获得职场优势。

AI不是淘汰人,而是淘汰不会用AI的人。选择AI门户,获取一站式AI工具分发便利服务。

你还等什么?和AI门户一起探索AI工具吧。

AI门户新媒体矩阵等你来关注

商务合作:

生态伙伴

无论是你是公司创始人,市场人员,文职人员,还是开发人员,你都能在这里找到适合自己的AI工具。

利用AI工具,你可以大幅提高工作效率,从容不迫的获得职场优势。

AI不是淘汰人,而是淘汰不会用AI的人。选择AI门户,获取一站式AI工具分发便利服务。

你还等什么?和AI门户一起探索AI工具吧。